知时数据中台

知时数据中台是基于分布式架构与云原生构建的大数据开发管理平台,是低代码、全流程、模块化支撑的架设数据中台的工具。支持多类型计算引擎。平台提供从标准、建模、指标、数据同步、数据开发、数据治理、数据分析、数据服务的一站式大数据全链路解决方案。通过此平台可构建PB级别数据仓库及进行数据价值的深度分析挖掘。平台采用开箱即用的使用方式,用户无需关心底层集群的搭建和运维。

通过知时数据中台,将对企业级海量数据进行采集、计算、存储、加工,同时统一标准和口径。将数据平台化统一治理后,会形成标准数据,再进行存储,形成大数据资产层,进而为客户提供高效数据服务,支撑企业用户数据中台建设与数字化转型。提供从数据采集、数据加工、数据建模、数据分析、报表展现的一体化的数据解决方案,自助式数据分析能力,全方位的数据分析场景,节省客户成本。为业务人员提供企业级数据分析工具和服务,满足不同类型的业务用户。

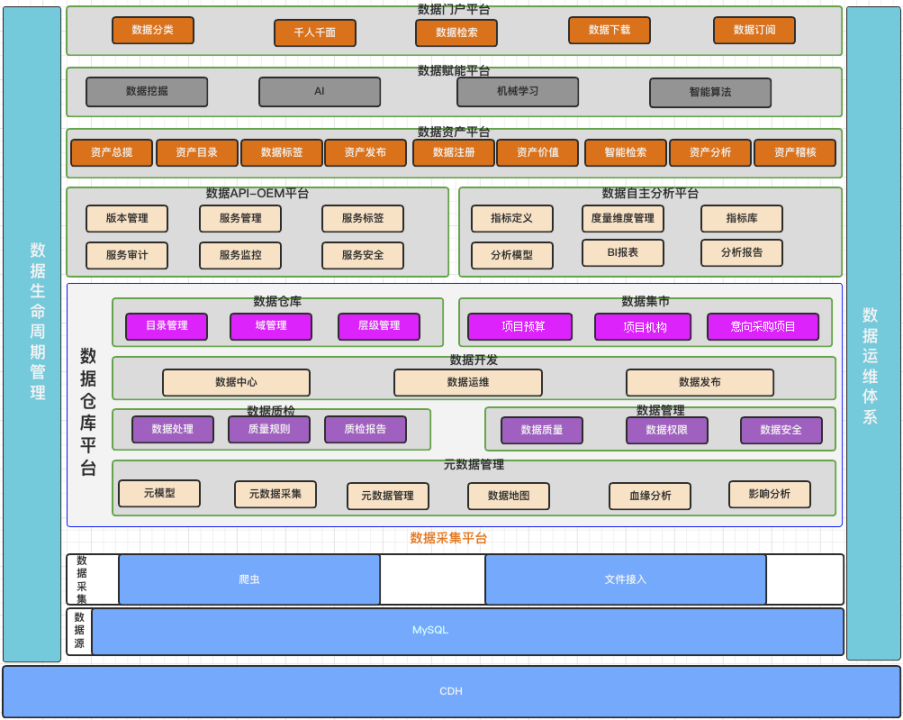

知时数据中台架构图

知时数据中台由数据集成(采集)平台、数据仓库平台、数据服务(API-OEM)平台、数据自主分析平台、数据资产平台、数据赋能平台和数据门户平台等七个平台支撑,各平台相互协作完成数据从接入、治理、分析赋能和对外共享交易的全生命周期的流转。

知时数据中台主要功能

数据集成(采集)

建立数据集成机制实现对各类型数据库、文件、业务系统之间的数据流通进行细粒度的管控,系统提供数据库、文件、接口多种数据适配方式接入数据,可以根据不同应用系统的实际情况进行选择合适的接入方式,将接入的数据进行预处理后,存储到数据库中,需要提供统一的监控、管理、配置中心,实现对数据汇聚服务的可视化配置,集中式管理和全方位监控。

数据库集成功能

采用向导方式定制数据采集,支持从关系数据库中采集数据,并经过清洗转换后,存储到目标数据库、目标文件服务器、目标消息服务器;支持国内外主流数据库,并且支持各种增量数据采集适配(触发器、时间戳、增量日志、SQL Server CDC等)功能。

文件集成功能

采用向导方式定制采集服务,从FTP服务器、Samba服务器、消息服务器中采集半结构化文件,并经过清洗转换后,存储到目标数据库、目标文件服务器、目标消息服务器。支持XML、CSV、Excel、JSON等格式数据的解析。

接口集成功能

通过调用业务系统的接口进行采集数据,支持从XML、JSON、Text等报文格式中提取数据内容,并存储到数据库中。

消息集成功能

提供对消息数据的适配功能,支持采集SOAP、REST、JMS、AMQP等协议传输的消息数据,并支持对常用消息数据格式进行解析(XML、CSV、Text、JSON等)。

在线填报

系统中需要提供多种不同种类的数据需要进行填报,为方便定义数据填报表单,不需要进行二次定制开发,提供在线表单设计功能。

网络爬虫集成

网络爬虫底层集成了python的rpa库,模仿人的操作对数据进行采集,通过内置框架,在开发中心进行python脚本开发,然后将节点设置成网络爬虫接口即可进行管理,进而屏蔽了采集源对采集过程的反制手段,使采集能够顺利完成对数据的采集。

数据开发

供可视化任务配置,多种脚本类型任务编写,通过拖拉拽的方式构建工作流任务,结合平台数据多维调度,助力数据仓库或集市的建设。在整个数据处理过程中,平台可以根据任务优先程度、资源消耗程度等不同维度来分配使用的内存和CPU等,并统一管理、实时监控。提供可视化的发布审核。用户自定义审批流,所有操作在平台留痕,方便后续出现问题快速追踪到相关人,及时解决。提供可视化监控数据处理的全过程。遇到各种因素导致的数据处理异常,可以及时向相关人员发起告警,并进行在线查看、跟踪、处理。

数据加工转换

采用市面上主流的Spark引擎和Flink引擎对不同结构的数据进行交换、同步、实时转换处理;

支持自定义算法和脚本开发模式增强数据加工转换能力。

数据运维

实时监控任务运行情况,并对异常任务发布告警信息;

对因不可抗因素导致工作流运行失败或者某个节点任务失败,可进行重跑和补批操作。

任务编排

支持以拖拽的操作形式进行自定义工作任务编排

依托参数/时间配置,形成依赖关系可视化的流程图,使工作流程简单易读,操作便捷。

数据资源隔离

支持多租户机制,支持任务资源分配与管理隔离;

支持单环境与多环境隔离的线上多用户进行协同数据开发。

数据管理

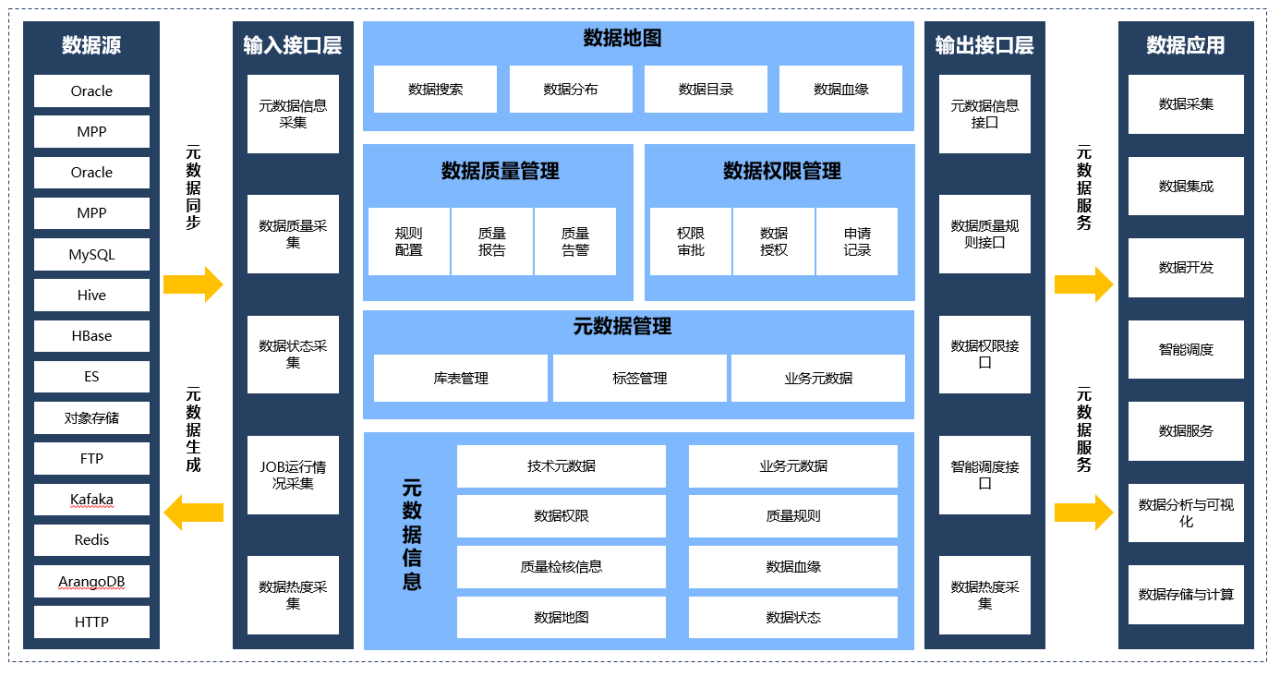

平台围绕了元数据管理、数据血缘追溯、数据质量管理和数据安全管理等进行展开,保障了用户能够快速了解企业内部数据结构和数据类型以及变化情况,能够快速了解上下游关联关系,并且要知道采用了哪些标准、哪些质量和如何保证的数据安全等。

元数据管理

元数据内容涉及到数据生命周期的各个数据环节,包括业务应用系统、数据同步、逐层加工、数据共享服务到最终应用展现的处理,元数据管理贯穿了整个流程,并与各环节实现有效互动。元数据是数据管理的基础,它对内容进行收集与共享,为ETL提供标准依据,驱动业务流程调度、数据质量稽核规则配置,为其他外部系统提供服务接口。

数据质量管理

通过建立数据质量评估机制和管理规范,及时发现、定位、监测、跟踪、解决各类数据质量问题,形成数据质量闭环处理,以保证数据质量稳定可靠。数据质量管理实现数据全生命周期的质量监控与质量稽核,包括数据接入、数据处理、数据存储、数据共享全过程,保障数据的完整性、准确性、一致性、及时性等。

数据安全管理

基于数据元数据体系,实现对不同类型存储的数据资源进行统一安全管理,屏蔽不同存储技术的细节,并且结合实际需求,建立起数据的安全管控机制和流程。

数据安全主要涉及数据访问控制、数据安全加工、数据服务安全以及相关的数据安全配置和数据安全审计方面的内容。

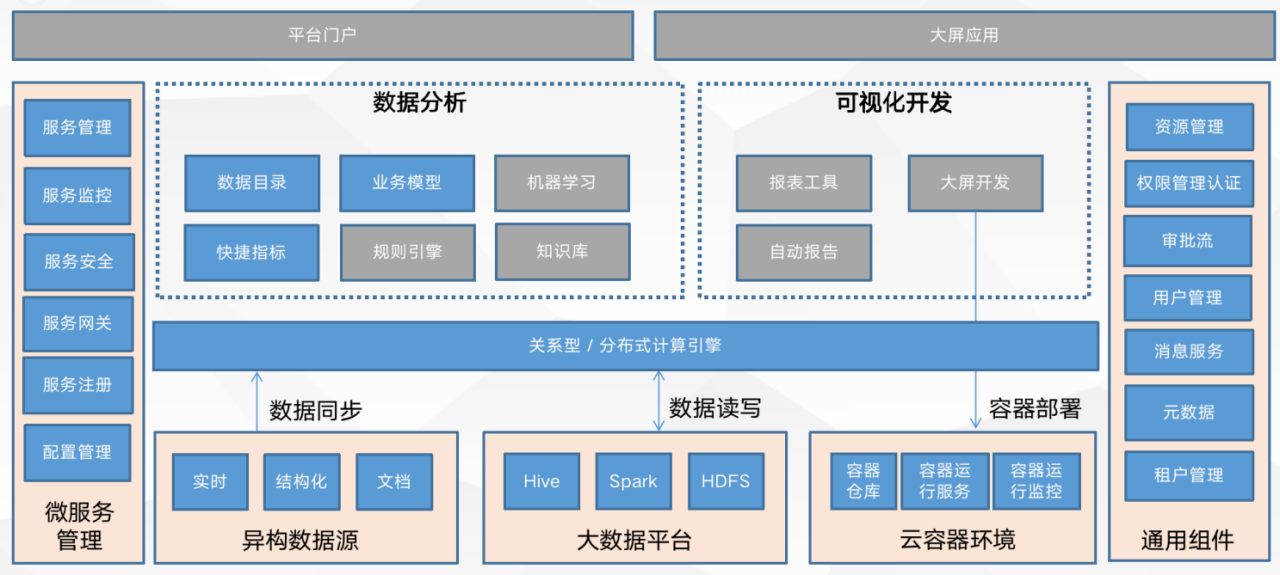

数据分析

数据分析从业务人员视角出发,基于友好的低代码技术,开箱即用的大数据处理能力,帮助业务人员迅速、快捷地完成数据分析工作,发掘数据中的业务价值。平台具备完整高效的数据收集能力,选用成熟的大数据存储架构,提供直观的图形化数据分析工具,可灵活地拖拽调整分析过程,并集成一套可视化工具,让使用者轻松获取分析结果。

数据目录

数据目录对平台的数据资源进行统一管理,通过对平台数据及相关资源进行归纳统合,并作为对外提供数据查询、浏览、访问等服务的出口,并使用平台数据进行业务模型等应用内容的构建。

业务模型构建分析

提供对系统中的数据资源可视化进行组合加工,形成新的数据。业务模型功能主要面向业务人员使用,帮助不需要非常高技术能力的业务人员通过低代码、图形化的方式,完成宽表加工、聚合统计、数据过滤等工作,从而达到降低业务——技术沟通成本,提升数据分析工作效率的目的。

业务模型由数据节点和连线组成,数据节点包括从数据目录来的原始数据资源节点和计算加工后的结果表节点。数据节点之间的连线表示各种数据节点之间的组合关系。一个业务模型可以包含多个原始数据资源节点、多个计算结果节点、多条关系连线。

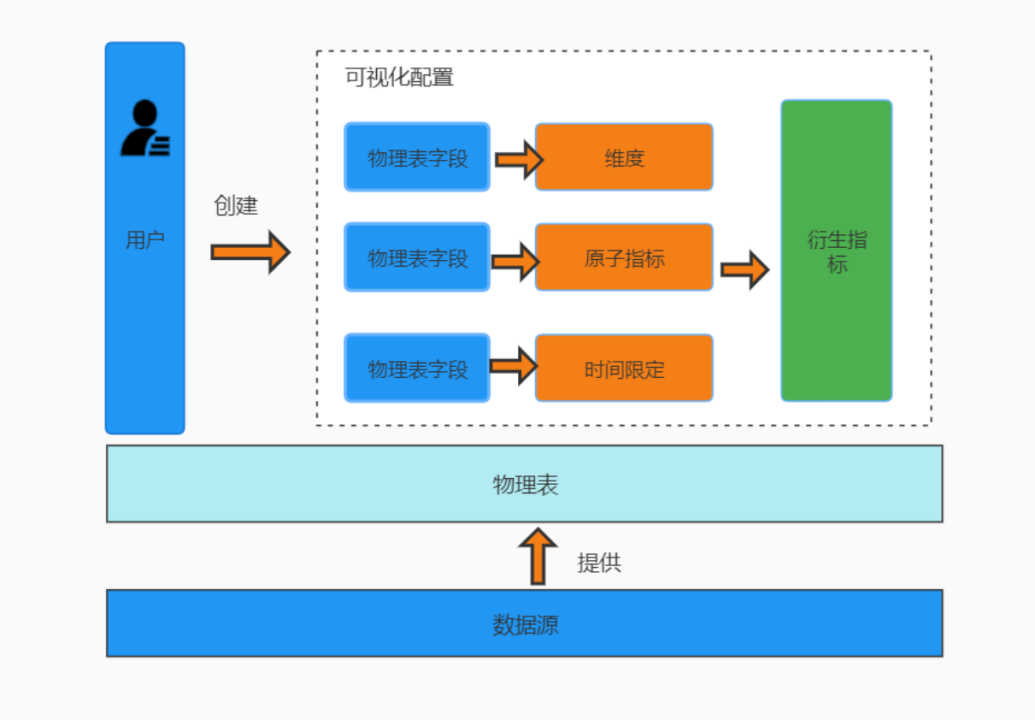

指标管理

指标管理

在实际的统计工作中,往往直接将说明总体数量特征的概念称为指标。一般从业务角度和技术角度定义指标。指标管理是集指标定义、数据建模和数据落地于一体,可以对指标维度、度量定制和统一管理。用户无需手动编写相关的指标相关的语句,减轻客户的压力。

报表管理

报表管理之报表设计制作功能,通过集成报表开发工具,帮助用户实现列报表、固定报表、仪表板类报表、以及各种数据大屏与数据报告的在线开发。

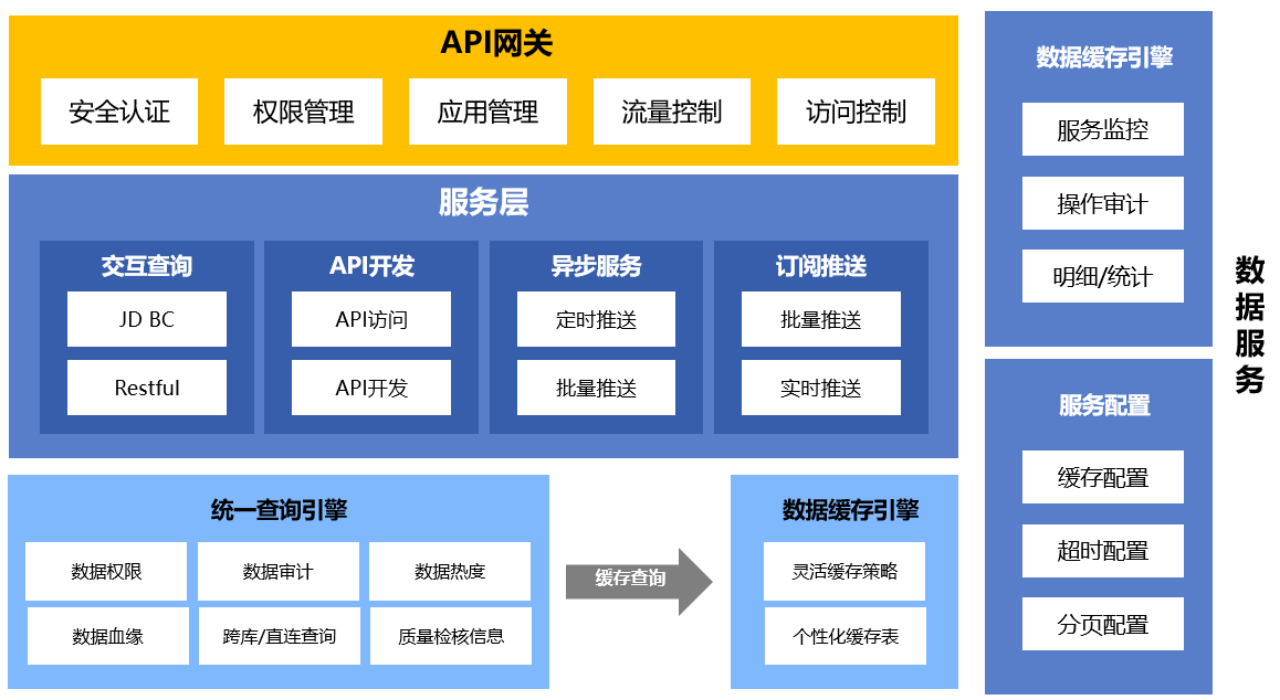

数据服务

旨在为企业用户提供统一的数据服务总线,统一管理对内对外的API服务。能够快速将主题数据表、数据资产、标签、算法模型、算法实验等生成数据API的能力,同时提供全链路、精细化、高可用的API全生命周期开发管理,一站式完成API发布、安全认证、调用流控等服务管控,提高数据开放与共享效率。

数据服务配置

可视化的数据服务分组配置,用户可根据业务及接口进行自定义数据服务组。

SQL数据服务

支持通过自定义SQL模板的方式,访问数据库数据,发布成为SOAP、REST接口服务,并且支持用户自定义输入、输出参数,并提供可配置的参数校验功能

数据表共享服务

支持将数据表或视图直接发布成SOAP、REST类型接口,并且提供数据表、字段级、记录级的数据授权访问功能

数据服务管理

通过数据服务配置自定义的接口通过发布,审批,启用等操作,上线对外提供的数据服务接口。

可对已经上线的接口,进行停止下线操作,终止对外提供。

对接口进行版本管理,并提供数据服务接口可调用时间参数,终止服务时间参数等配置项。

提供各类条件的查询功能,便于灵活的查询需要的目标接口。

数据服务安全认证

对服务访问提供身份认证机制,确保应用安全地访问提供的服务,需要支持多种身份认证方式:Token认证、HTTP Basic认证、用户密码。

服务安全审计

审计服务的访问情况,哪些服务被哪些用户成功访问,哪些被拒绝访问。对不在服务授权列表中的非法用户访问,提供黑名单审计功能,有效判断服务的安全性。

服务安全防护

提供REST、SOAP防护功能,实现对第三方业务服务、数据接口服务进行安全防护拦截,能够进行输入参数、流量进行安全控制